Mistral AI 简介

Mistral AI 是一家位于法国巴黎的人工智能初创公司。该公司由前谷歌DeepMind和Meta公司的研究人员于2023年创立,致力于开发尖端的大型语言模型(LLM),并专注于开源解决方案,旨在成为美国科技巨头在AI领域的主要欧洲竞争者。

自成立以来,Mistral AI凭借其高效、强大的模型和对开源社区的贡献,迅速成为全球人工智能领域的关键参与者。

Mistral AI 最新动态

- 2025年6月10日 Mistral AI发布了Magistral Small和Magistral Medium模型,据称具有思维链能力。

- 2025年6月11日 Mistral AI宣布推出Mistral Compute,这是一个AI基础设施平台,旨在帮助公司、主权国家和研究机构构建和管理其AI堆栈。

- 2025年5月7日 Mistral AI发布了Mistral Medium 3。

- 2025年3月17日 Mistral发布了Mistral Small 3.1,这是一个更小、更高效的模型。

- 2025年2月6日 Mistral AI在iOS和Android上发布了其AI助手Le Chat,提供网络搜索、图像生成和实时更新等功能。

Mistral AI 概览

- 公司名称: Mistral AI

- 成立时间: 2023年4月

- 创始人: Arthur Mensch, Guillaume Lample, Timothée Lacroix

- 总部: 法国,巴黎

- 核心业务: 开发大型语言模型、提供AI模型API服务

- 公司使命: 打造开放、高效、可信赖的人工智能,推动技术普及和创新。

- 市场定位: 领先的开源AI模型提供商,欧洲在生成式AI领域的领导者。

Mistral AI 发展历史

- 2023年4月:公司由Arthur Mensch(前DeepMind研究员)以及Guillaume Lample和Timothée Lacroix(前Meta研究员)共同创立。

- 2023年6月:Mistral AI在成立仅一个月后,便完成了创纪录的1.05亿欧元(约1.13亿美元)种子轮融资。

- 2023年9月:公司发布了其首个模型 Mistral 7B。该模型尽管参数量仅为70亿,但在多项基准测试中的表现优于参数量更大的同类模型(如Llama 2 13B),因其卓越的效率而备受赞誉。该模型采用Apache 2.0许可证完全开源。

- 2023年10月: Mistral AI筹集了3.85亿欧元。

- 2023年12月:发布了 Mixtral 8x7B,这是一款采用稀疏混合专家(Sparse Mixture of Experts, SMoE)架构的高性能开源模型。同时,公司宣布完成4.15亿美元的新一轮融资,并推出了其首个商业化API平台“Le Plat Roulant”。

- 2023年12月: Mistral AI估值超过20亿美元。

- 2024年2月:Mistral AI发布了其首款闭源旗舰模型 Mistral Large,并宣布与微软建立重要的战略合作伙伴关系。通过此次合作,Mistral AI的模型登陆微软Azure AI平台,面向全球企业客户提供服务。

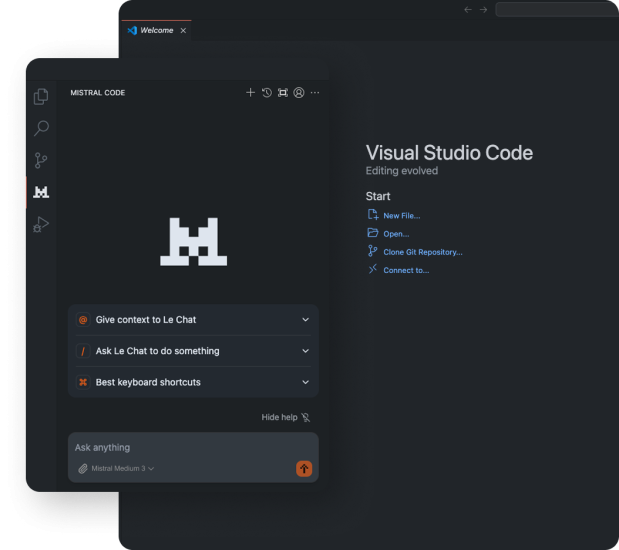

- 2024年5月:发布了专为代码生成和补全设计的开源模型 Codestral,支持超过80种编程语言。

- 2024年6月: Mistral AI获得了由General Catalyst牵头的6亿欧元(6.45亿美元)融资,估值达到58亿欧元(62亿美元)。

- 2024年12月:公司宣布完成新一轮6亿欧元的融资,由General Catalyst领投,公司估值达到58亿欧元。

- 2025年2月6日: Le Chat移动应用程序发布。

- 2025年3月17日: 发布Mistral Small 3.1。

- 2025年5月7日: 发布Mistral Medium 3。

- 2025年6月10日: 发布Magistral Small和Magistral Medium。

Mistral AI主要模型与版本

Mistral AI的产品线分为两大类:完全开源的开放权重模型和通过API提供服务的优化商业模型。

Mistral AI开放权重模型 (Open-weight Models)

- Mistral 7B:

- 参数量:73亿

- 特点:公司发布的第一个模型,以其极高的效率和性能著称。采用滑动窗口注意力(Sliding Window Attention, SWA)机制,有效处理长序列文本。

- Mixtral 8x7B:

- 架构:稀疏混合专家(SMoE)

- 特点:模型内部包含8个“专家”网络,在处理每个token时仅激活其中2个。这种架构使其在保持较低推理成本的同时,拥有与更大模型相媲美的性能。总参数量约467亿,但单次推理激活参数仅129亿。

- Mixtral 8x22B:

- 架构:稀疏混合专家(SMoE)

- 特点:Mixtral 8x7B的升级版,拥有8个220亿参数的专家,总参数量达1410亿。在多语言能力和知识广度上进一步提升,是目前最强大的开源模型之一。

- Codestral:

- 参数量:220亿

- 特点:专为代码任务优化的模型,支持超过80种编程语言,在代码生成、补全和修复任务上表现卓越。

Mistral AI商业模型 (Commercial Models)

通过其API平台“Le Plat Roulant”提供服务。

- Mistral Large:

- 定位:旗舰模型,性能对标GPT-4。

- 特点:拥有顶级的推理能力,支持32K tokens的上下文窗口,具备强大的多语言能力(法语、德语、西班牙语、意大利语表现突出)和函数调用(Function Calling)功能。

- Mistral Small:

- 定位:低延迟、低成本的优化模型。

- 特点:性能优于Mixtral 8x7B,适用于需要快速响应的大规模应用场景。

- Mistral Embed:

- 定位:嵌入模型。

- 特点:用于将文本转换为高维向量表示,支持检索增强生成(RAG)等应用。

Mistral AI核心特点与技术优势

- 开源优先:Mistral AI坚定地支持开源,其发布的开源模型性能强大且完全免费商用,极大地推动了AI社区的发展和技术的普及。

- 创新架构:率先在主流模型中成功应用**稀疏混合专家(SMoE)**架构,实现了性能与效率的完美平衡,为大模型的发展开辟了新路径。

- 计算效率:通过**滑动窗口注意力(SWA)和滚动缓冲区缓存(Rolling Buffer Cache)**等技术,Mistral AI的模型在处理长序列时,显著降低了内存占用和计算成本。

- 欧洲领导地位:作为欧洲最耀眼的AI公司,Mistral AI被视为平衡美国在AI领域主导地位的重要力量,获得了欧洲各国政府和机构的大力支持。

- 强大的多语言能力:其模型在设计之初就考虑了多语言支持,在法语、德语、西班牙语等非英语语种上表现尤为出色。

Mistral AI 官网

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

暂无评论内容