OpenAI再次颠覆人们对于AI的想象,这就是Magic!

5月14日,OpenAI春季新品发布会正式召开

这个时间的选择十分的有趣,因为明天的同一时间就是Google I/O开发者大会

不过正如Sam Altman所说“不是GPT-5,不是搜索引擎”,或许这让明天的Google 悄悄疏了口气

但比搜索功能更炸裂的是全新GPT-4o模型的发布!

| GPT-4o模型

GPT-4o,“o”代表“omni”,它可以接受任意组合的文本、音频和图像作为输入,并生成任意组合的文本、音频和图像输出。

是的,它的处理能力横跨,说,听,读,看!

可以实时对音频、视觉和文本进行推理,交流响应时间可以短至 232 毫秒,平均时间为 320 毫秒,与正常用户对话时间接近

此外在英语文本和代码上的性能与 GPT-4 Turbo 的性能相匹配,在非英语文本上的性能显著提高

最最最重要的是,免费可用!

之前沸沸扬扬的im-a-good-gpt2-chatbot,OpenAI研究科学家William Fedus刚刚发文,表示正是GPT-4o

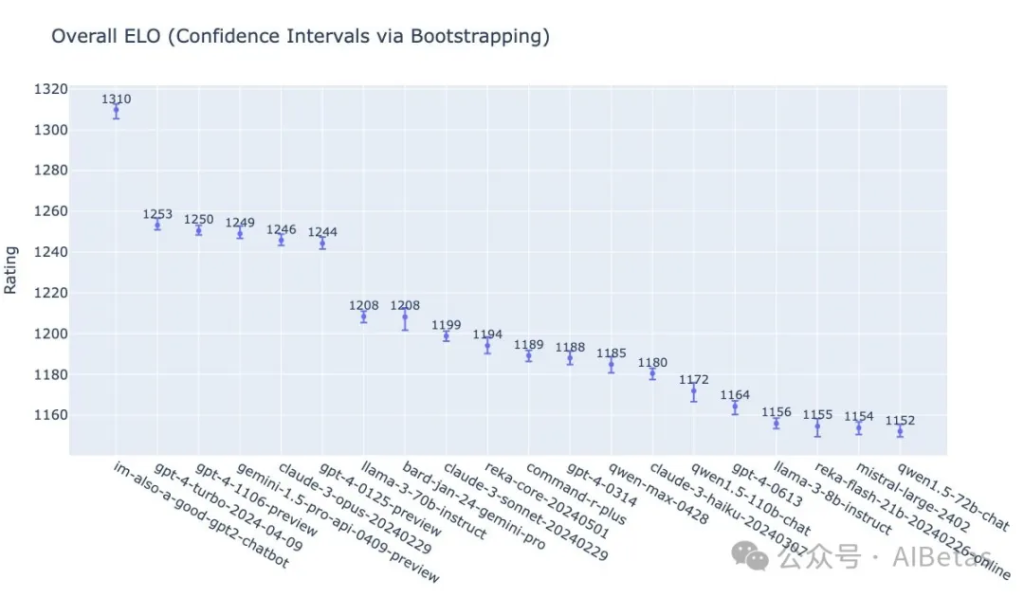

而在评测排行榜上,ELO分数超过了GPT-4-Turobo

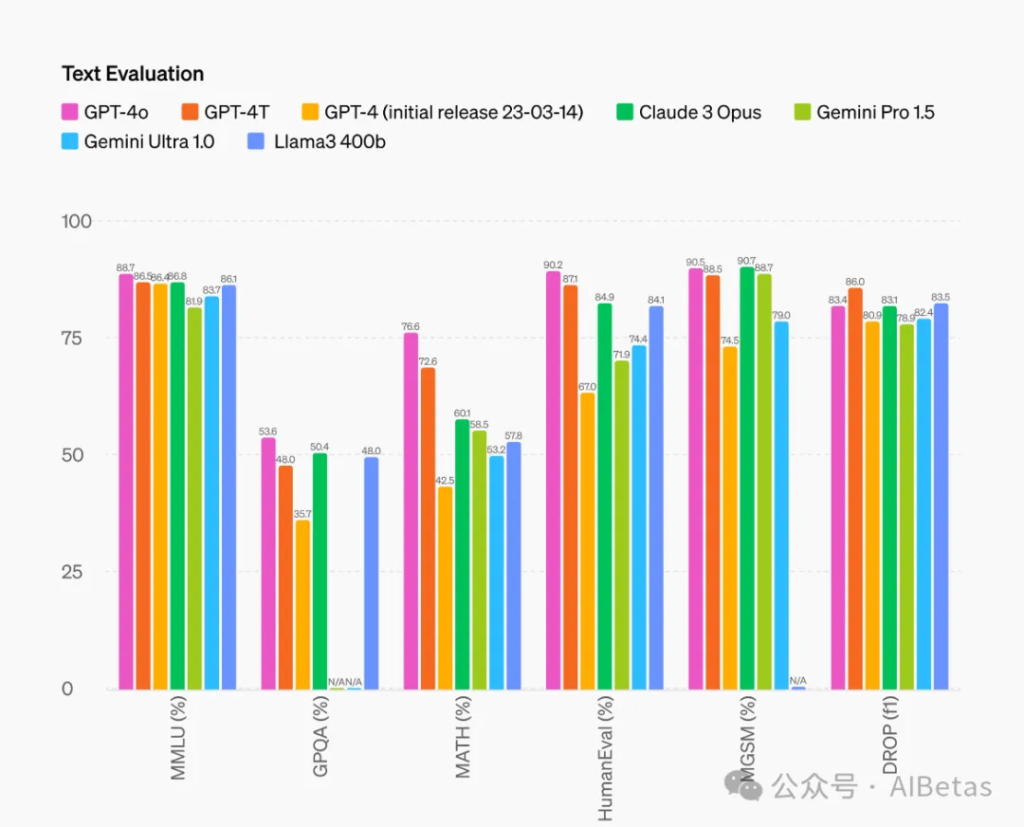

首先看看GPT-4o能力的评测结果

文本能力

音频识别能力

GPT-4o 比 Whisper-v3 显著提高了所有语言的语音识别性能,特别是对于资源匮乏的语言。

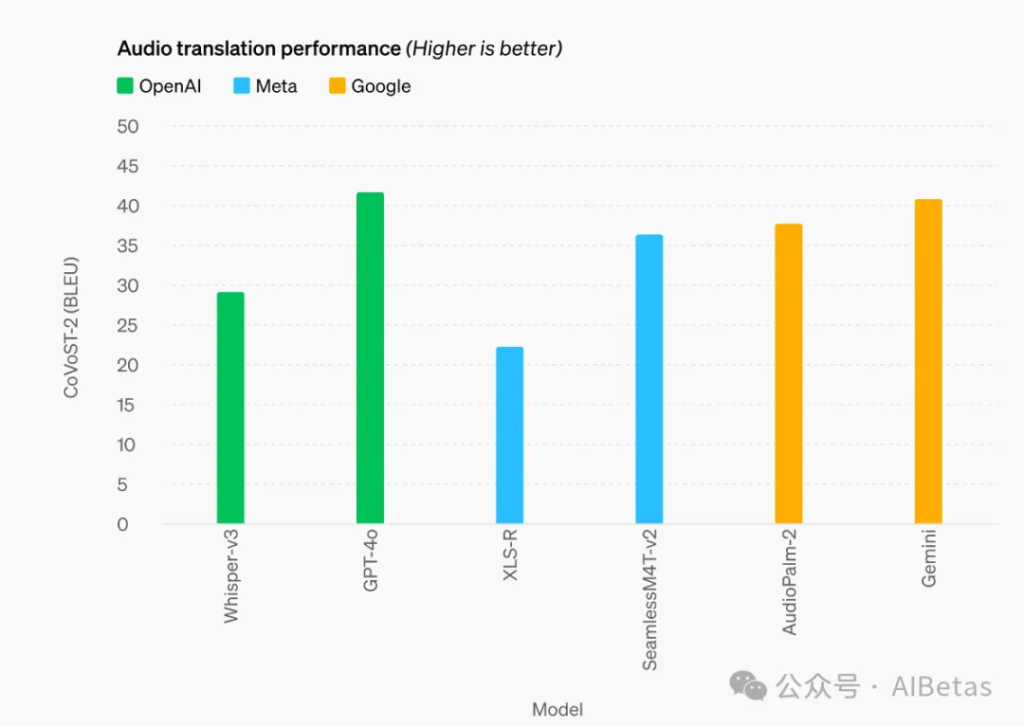

音频翻译能力

GPT-4o 在语音翻译方面树立了新的最先进水平,并且在 MLS 基准测试中优于 Whisper-v3。

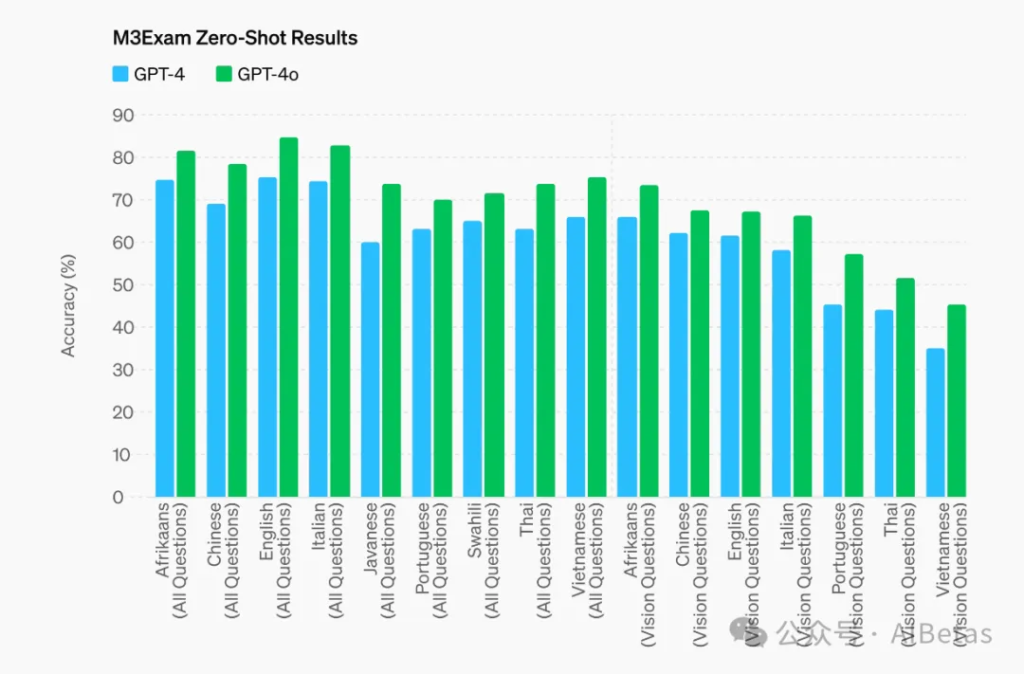

语言能力

M3Exam 基准测试既是多语言评估也是视觉评估,由来自其他国家标准化测试的多项选择题组成,有时还包括图形和图表。在所有语言的基准测试中,GPT-4o 都比 GPT-4 更强。

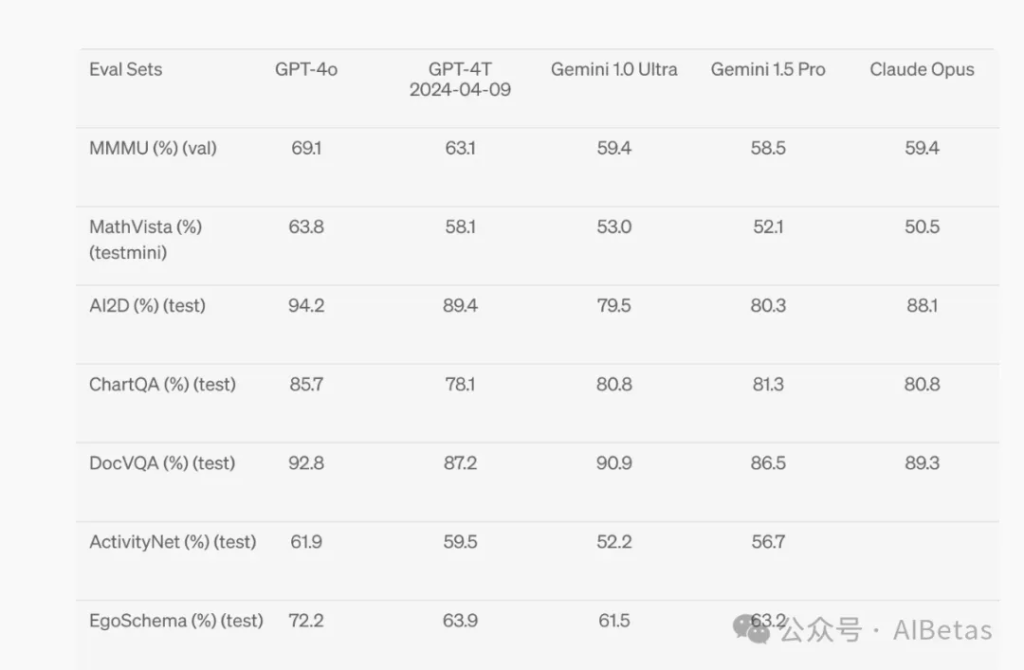

视觉理解能力

整体的能力测试来看,GPT-4o在各项的测试中,在文本、推理和编程智能方面达到了GPT-4 Turbo级别的性能,在多语言、音频和视觉能力方面更是显著领先于其他模型!

GPT-4o 的文本和图像功能今天开始在 ChatGPT 中推出。同时正在免费套餐中提供 GPT-4o,并向 Plus 用户提供高达 5 倍的消息限制。

打开ChatGPT已经可以选择GPT-4o模型

![图片[9] - OpenAI春季发布会召开,GPT-4o震撼发布,人人都可以拥有自己的“MOSS” - AIBetas](https://www.aibetas.com.cn/wp-content/uploads/2024/05/image-30.png)

同时,将在未来几周内在 ChatGPT Plus 中推出新版本的语音模式 GPT-4o alpha。

开发人员现在还可以在 API 中访问 GPT-4o 作为文本和视觉模型。与 GPT-4 Turbo 相比,GPT-4o 速度提高 2 倍,价格降低一半,速率限制提高 5 倍

| 桌面端更新

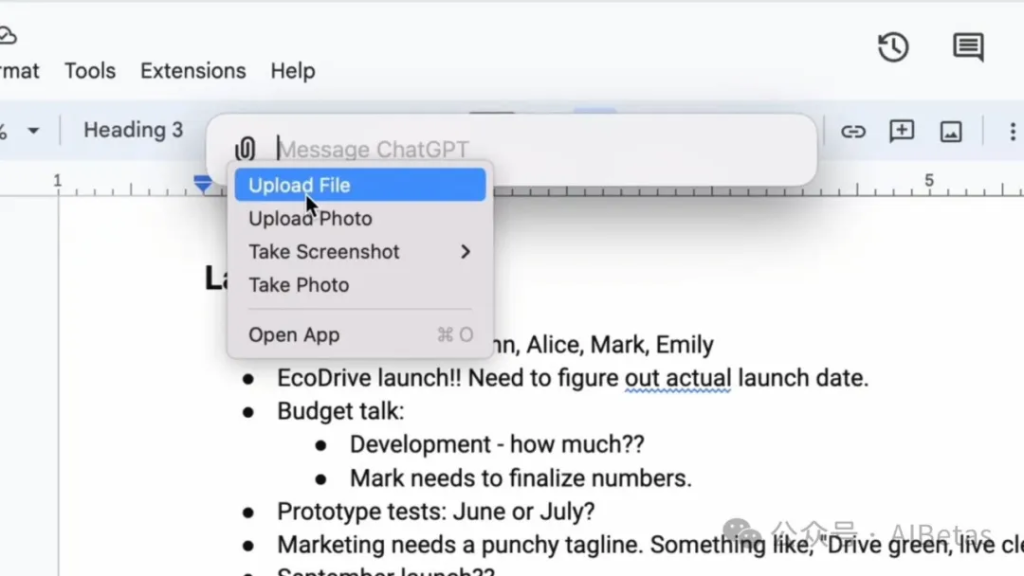

此外,ChatGPT也推出了适用于 macOS 的新 ChatGPT 桌面端

通过简单的键盘快捷键(Option + Space),可以立即向 ChatGPT 提问,还可以直接在应用程序中截取屏幕截图并进行讨论

还可以直接和ChatGPT对话

同时,为 ChatGPT 引入了新的外观和感觉,旨在更加友好和更具对话性

| 结语

Sam将这次的更新描述为《Her》,或许也是Moss,也是贾维斯

虽然此次的更新没有GPT-5,没有Sora

但这一次,OpenAI让我看到了更多更实际的应用的场景。更向普通用户贴合

一直坚信工具的最终的归宿都是用户,满足用户的需求才是AI产品的最终的归宿

希望有一天,人人都能有属于自己的MOSS,自己的贾维斯

压力给到明天的Google

已经看到这里了,如果这篇文章对你有帮助,求个点赞,分享,转发,谢谢你的阅读!

暂无评论内容